Apache Hudi 統一批處理和近實時分析的現代化數據湖存儲層

在數據驅動的時代,企業面臨著處理海量數據并從中快速獲取價值的挑戰。傳統的數據架構往往將批處理(處理歷史、大批量數據)和流處理(處理實時、連續的數據流)割裂開來,使用不同的存儲系統和計算引擎,導致了數據孤島、處理復雜性和高昂的運維成本。Apache Hudi(Hadoop Upserts Deletes and Incrementals)應運而生,旨在解決這一核心痛點,為數據湖提供了一個統一的存儲和服務層,無縫地橋接了批處理和近實時分析。

一、Apache Hudi 的核心定位與價值

Apache Hudi 是一個開源的數據湖表格式(Table Format),它構建在分布式文件系統(如 HDFS 或云對象存儲 S3、OSS)之上。其核心價值在于將數據庫的功能(如高效的更新、刪除、事務控制)引入到大數據存儲中,同時保持了數據湖的開放、可擴展和成本效益。

Hudi 實現了數據處理與存儲服務的統一,具體體現在:

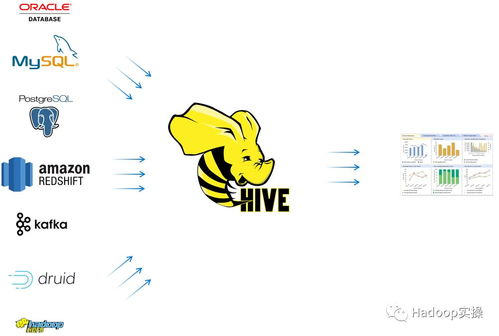

- 統一存儲:同一張 Hudi 表可以同時服務于批處理作業(如 T+1 的 ETL、歷史數據報表)和流處理作業(如實時儀表盤、事件驅動應用)。數據只需寫入一次,即可被多種計算引擎(如 Apache Spark、Flink、Trino/Presto、Hive)以批或流的方式讀取。

- 統一服務:Hudi 不僅存儲數據,還通過其表服務(如壓縮、清理、聚類)主動管理數據布局,優化查詢性能。它提供了增量查詢、快照查詢等多種數據消費模式,讓下游應用能靈活、高效地獲取所需數據視圖。

二、實現批流統一的關鍵技術

Hudi 通過其獨特的數據組織模型和表管理功能,實現了這一宏偉目標:

1. 表類型與查詢類型

* Copy-On-Write (COW):在寫入時直接合并新數據與舊文件,生成新的數據文件版本。它提供了最佳的讀取性能,因為讀取時總是獲取最新的、已合并的文件,非常適合查詢頻繁、對數據延遲要求較高的近實時分析場景。

- Merge-On-Read (MOR):新數據先寫入到高效的增量日志文件中,查詢時動態合并基礎文件和日志文件。這極大地優化了寫入延遲,支持更高的數據攝取吞吐量,同時仍能通過讀時合并或后臺壓縮服務提供近乎實時的數據視圖。

2. 增量處理范式

Hudi 引入了“增量查詢”的概念。與傳統的全表掃描不同,下游作業可以只拉取自上次檢查點以來發生變化的數據記錄。這從根本上改變了數據處理管道:

- 批處理:可以配置為定期的增量 ETL,只處理新數據,效率極高。

* 流處理:近實時分析管道可以持續消費增量數據流,實現分鐘級甚至秒級的延遲。

這種模式統一了批和流的處理邏輯,許多管道只需編寫一次,即可同時支持兩種處理頻率。

3. 事務與時間旅行

Hudi 通過時間軸(Timeline)管理所有對表的操作,提供了 ACID 事務保證。這意味著即使在并發寫入和讀取的場景下,數據的一致性也能得到保障。時間旅行能力允許用戶查詢某個歷史時間點的數據快照,這為數據回溯、審計和基于時間點的分析提供了強大支持。

三、數據處理與存儲服務的實踐場景

場景一:近實時數據倉庫與實時報表

交易、日志或 IoT 數據通過 Kafka 等消息隊列持續流入。利用 Apache Flink 或 Spark Structured Streaming,以 MOR 表類型將數據低延遲地寫入 Hudi 表。后臺的壓縮服務會定期合并日志文件以優化讀取。BI 工具(如 Superset、Tableau)通過 Trino 直接查詢 Hudi 表,分析師既能運行復雜的批量歷史分析,也能在儀表盤上看到不斷更新的近實時業務指標。

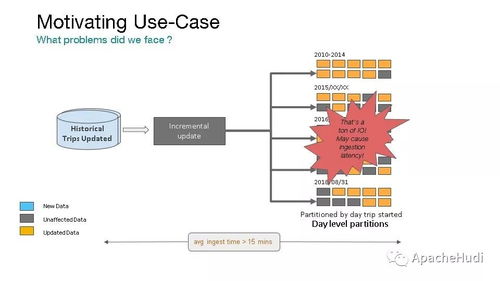

場景二:高效的增量數據管道

傳統的 T+1 全量數據同步和計算任務耗時耗力。引入 Hudi 后,數據集成任務只需將每日變更(增、刪、改)以增量方式同步到 Hudi 表。下游的數據質量檢查、聚合計算、特征工程等批處理作業,全部轉為增量處理模式,運行時間從數小時縮短到數十分鐘,資源消耗大幅降低。

場景三:流式數據湖與機器學習

在推薦系統或風控場景中,模型需要最新的用戶行為特征。用戶實時交互數據被寫入 Hudi 表,特征計算作業通過增量查詢快速提取最新特征,更新特征庫。訓練和推理管道可以按需讀取特定時間范圍的全量或增量數據,實現了數據湖到特征存儲的流式閉環。

四、與展望

Apache Hudi 通過將數據庫的核心能力與數據湖的規模經濟相結合,成功構建了一個統一、高效、可靠的數據存儲與服務層。它打破了批處理與流處理之間的壁壘,使組織能夠以更低的成本和更高的敏捷性構建現代化的數據架構。隨著云原生和湖倉一體(Lakehouse)概念的普及,Hudi 憑借其對事務、更新刪除和增量處理的卓越支持,正與 Iceberg、Delta Lake 等一起,成為構建下一代企業級數據平臺的關鍵基石。對于任何尋求簡化數據架構、統一數據服務并加速從數據中獲取價值的企業而言,深入理解和應用 Apache Hudi 都將是一個極具戰略意義的選擇。

如若轉載,請注明出處:http://www.simaoarabica.com.cn/product/57.html

更新時間:2026-02-17 08:26:45